新旧GPU对决:Blackwell凭啥更能打?

本周,亚马逊网络服务宣布推出其首款基于 Nvidia 的「Grace」CG100 CPU 和「Blackwell」B200 GPU 的 UltraServer 预配置超级计算机,称为 GB200 NVL72 共享 GPU 内存配置。这些机器被称为 U-P6e 实例,实际上有全机架和半机架配置,它们补充了去年 12 月在 re:Invent 2024 会议上推出的现有 P6-B200 实例。

在 P6 和 P6e 实例的情况下,GPU 和 NVLink Switch 4 GPU 内存共享交换机上的 NVLink 5 端口用于将 GPU 组整合到大型共享内存计算复合体中,类似于 CPU 服务器存在了 25 多年的 NUMA 集群。其他非 NUMA 共享内存架构比非统一内存访问技术更古老,如对称多处理或 SMP,但没有像 NUMA 在 CPU 上的扩展,在单核处理器时代,NUMA 在共享内存集群中推到了 128 和 256 个 CPU。

基于 Nvidia NVL72 设计的 P6e 实例,我们在这里详细介绍了这些设计,GPU 内存域横跨 72 个 GPU 插槽,Blackwell 芯片每个插槽有两个 GPU 芯片,因此内存域实际上是单个机架中的 144 个设备。AWS 正在销售具有 72 或 36 个 Blackwell B200 插槽的 UltraServers 作为内存域,估计这是虚拟完成的,而不是物理完成的,因此可以即时配置实例大小。这些机器每两个 Blackwell B200 GPU 配对一个 Grace CPU,整个 shebang 是液冷的,这也是 B200 GPU 超频 11% 的原因之一,并为人工智能工作负载提供更多的原始计算性能。

P6 实例使用更标准的 HGX-B200 服务器节点,这些节点没有超频,并创建了一个跨越八个套接字的 GPU 内存域。P6 实例使用英特尔至强 6 处理器作为其主机计算引擎,每八个 Blackwell B200 GPU 有两个 CPU,产生的计算复合体密度是 GB200 NVL72 系统的一半,因此仍然可以风冷。

随着这两个 Blackwell 系统现在在 AWS 云上可用,并且价格信息可用,现在是对 Blackwell 实例进行一些价格/性能分析的最佳时机,与前几代「Hopper」H100 和 H200 GPU 以及基于「Ampere」A100 和「Volta」V100 GPU 的早期实例进行一些价格/性能分析,这些实例仍然可以在 AWS 云上租用。

我们检查的实例和 UltraServer 机架规模配置是在 AWS 所谓的 EC2 容量块下出售的,顾名思义,这是预订和购买预配置的 UltraClusters 的一种方式,其大小从一个实例或 UltraServer 到多达 64 个实例或机架,期限长达六个月,最多在您需要容量的八周前。这是一个预留实例的时髦版本,以更大的块状形式作为单个单元出售。

只是为了好玩,我们采取了 EC2 容量块配置,还找到了按需定价的设置,看看这些在成本上如何比较,一直到基于 Nvidia Volta GPU 的 P2 实例和基于 Ampere GPU 的 P3 实例。

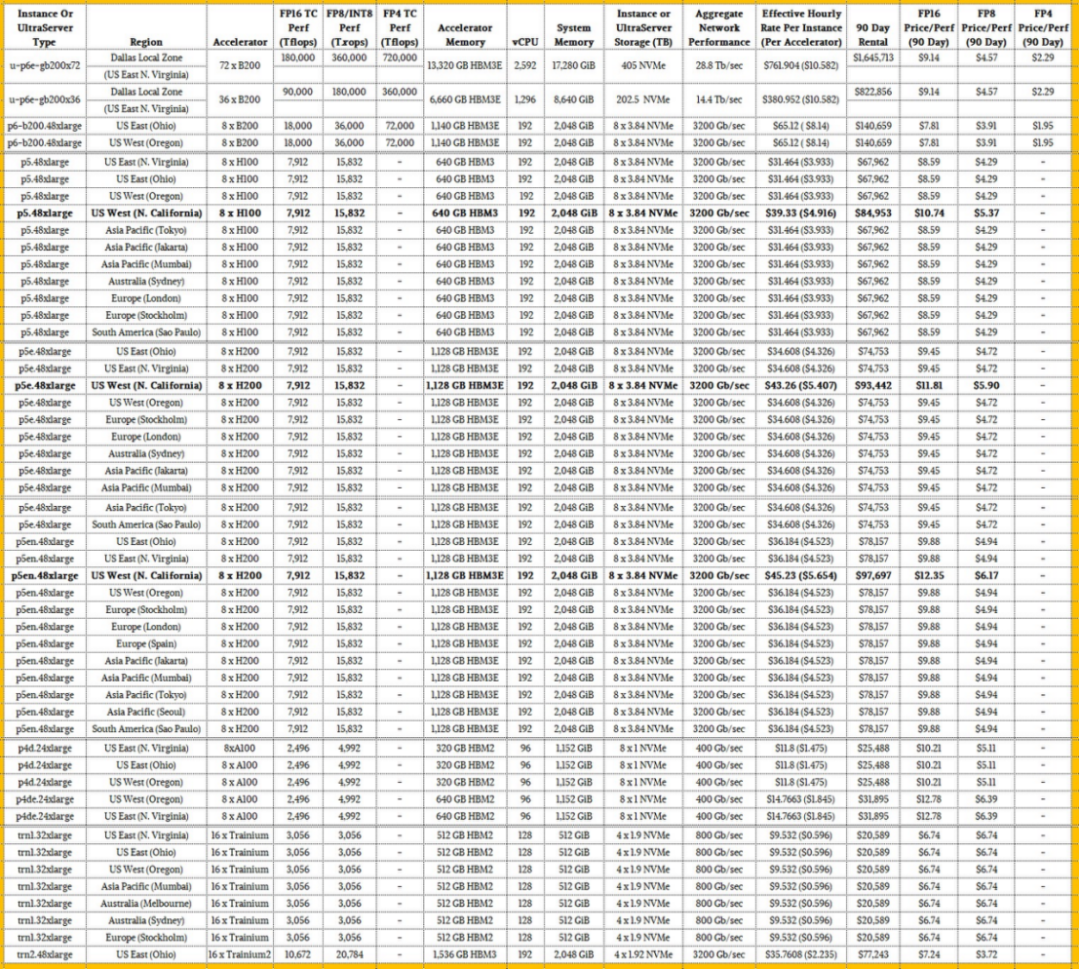

因此,未来不假说,这是 EC2 容量块的所有电子表格的母体,价格显示在全球可用的地区,包括 Nvidia GPU 实例以及 AWS Trainium1 和 Trainium2 实例:

那里有很多东西需要接受。为了了解价格/性能是如何叠加的,我们添加了 FP16、FP8 或 INT8 和 FP4 精度的峰值理论性能。为了进行比较,我们忽略了 FP64 和 FP32 精度,充分意识到有时更高的精度计算用于人工智能模型,当然也用于 HPC 模拟。这些性能评级适用于密集数学,而不是稀疏矩阵,这可以使设备的有效数值吞吐量翻倍。

我们决定,90 天的租赁代表了训练一个相当大的模型需要什么,但没什么疯狂的。这种实例成本的规模产生了一个很好的红利,其中除数将它切成太浮点运算的性能。

很多东西都跳出这个怪物表,但我们看到的第一个,我们用粗体强调的是,AWS 对基于美国西北加州地区提供的 Hopper H100 和 H200 GPU 的 GPU 实例收取 25% 的溢价。在硅谷很难获得电力和数据中心空间,这就是为什么你看到美国西部地区的俄勒冈州地区安装了这么多新设备。美国东部地区锚定在弗吉尼亚州阿什本周围,它仍然首先获得许多好东西,包括基于 GB200 NVL72 设计的 UltraServer P6e 机架系统。正如你所看到的,俄亥俄州的美国东部地区也获得了新东西的份额,包括 Trainium1 和 Trainium2 集群。

我们认为 FP16 性能是人工智能加速器的基线,然后 FP8 和 FP4 精度是模型的重要进一步加速器,这些模型可以使用较低分辨率的数据进行训练,并且仍然不会牺牲模型的准确性。

如果你看一下机架式 GB200 NVL72 系统的 FP16 性能与 HGX-B200 系统相比,后者的扩展幅度没有那么大,机架式机——需要液体冷却,安装有点像野兽——与 AWS 租用的方式相比,单位性能仅提高了 17%。这其实并不是什么溢价,考虑到系统的密度以及 GB200 NVL72 的密度导致的电源和冷却问题,这符合您的预期。

您将看到的另一件事是,H100 和 H200 设备具有相同的峰值理论性能,但 AWS 安装的 H100 是较早的,只有 80 GB 的 HBM3 容量,而 H200 具有 141 GB 的 HBM3 容量。AWS 正在为该内存和附带的更高带宽收取 10% 的溢价。带有 80 GB HBM3 的 H100 带宽为 3.35 TB/秒,而带有 141 GB HBM3E 的 H200 提供 4.8 TB/秒的带宽。对于许多工作负载,这种额外的内存容量和带宽几乎可以使人工智能培训的实际性能增加一倍。您可能期望 AWS 对 H200 实例收取比它更多的溢价。

EC2 容量块仍然可以使用 Ampere A100 GPU 加速器获得,有趣的是,按 GPU 计算,H200 比 A100 贵 3.07 倍,但它每个 GPU 的 FP16 性能高 3.17 倍。当你计算时,通过容量块租用具有 40GB HBM2 内存的 A100 90 天,每兆浮点运算的成本为 10.21 美元,而 H100 的每兆浮点运算成本为 9.88 美元。只有当你无法获得 H100s、H200s 或 B200s 时,你才会这样做。带有 80GB HBM2 内存的 A100 每 TBflops 售价为 12.78 美元。(所有这些价格都适用于北加州以外的地区。)

在 FP16 精度下,P6e 实例中的全尺寸 NVL72 机器,配有 72 个 Blackwell B200 GPU,以及带有 36 个 Blackwell B200 的半机架,每兆浮点运算成本为 9.14 美元,租金为 90 天,这三个月将分别花费 165 万美元和 822,856 美元。具有较小内存域的 P6-B200 实例在 FP16 精度下,在 90 天内每兆浮点运算花费 7.81 美元,鉴于这些实例是空气冷却的,内存域较小,这是有道理的。神奇的是,液冷 GB200 NVL72 机器的价格并不高。

如果你看一下 FP8 的性能,每太浮点运算的所有成本都减半了,而 Blackwells,以 FP4 格式计算的能力将一亿浮点运算的成本再次减半。最终结果是,如果您更改模型以利用 FP4 性能,您可以租用四分之一的机器以四分之一的成本完成相同的工作,或者您可以花费相同的钱来训练一个大四倍的模型。

现在看看桌子的底部和 Trainium。在原始 FP16 吞吐量方面,需要两倍于 AWS 设计的 Trainium1 人工智能加速器才能击败 Nvidia A100 约 22%。使用 Trainium2,FP16 的性能提高了 3.5 倍,FP8 的性能提高了 6.8 倍,而 HBM 容量提高了 3 倍,但在 FP16 分辨率下,每兆浮点运算的成本仅提高了 7.4%。增加 FP8 将 FP8 精度的太浮点运算的价格降低到仅 3.72 美元,这低于 AWS 租用的 HGX-B200 节点作为 P6 实例的每兆浮点运算 3.91 美元,甚至低于 AWS 为 GB200 NVL72 实例收取的每兆浮点运算 4.57 美元。Trainium2 不支持 FP4,这意味着在原始成本方面,Nvidia 对那些可以以 FP4 分辨率运行且不会失去准确性的人工智能应用程序具有优势。

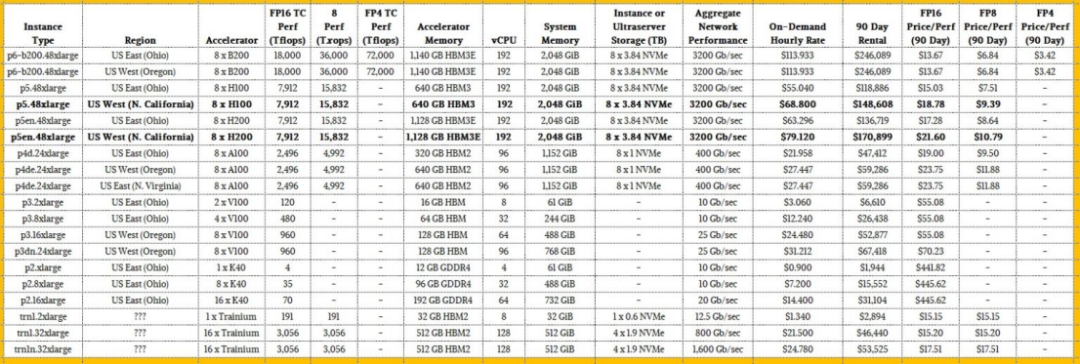

现在,如果您查看 AWS 上的按需定价,Trainium1 芯片仍然可用,而且它们比按需租用的 Blackwell B200 实例要贵得多。看一看:

本表中显而易见的是,基于 K40、V100 和 A100 GPU 的古代加速器实例成本非常低,因此资本支出非常低,这看起来很有吸引力,但如果你看一下 FP16 ooph 的太浮点运算成本,这些在经济意义上是可怕的,并且与 EC2 容量块计划下出售的新铁的差距要大得多。如果您将这些在 FP16 模式下运行的古老 GPU 与在 FP4 模式下运行的 Blackwells 进行比较,除了在绝对紧急情况下,否则考虑使用这种旧的熨斗是彻头彻尾的愚蠢。

显然,如果您需要按需租用实例,请租用 Blackwells 并在 FP4 模式下运行。如果你这样做,FP16 性能的成本会降低 9%,通过精密两档的降档,你可以将性能提高 4 倍,将性价比提高 4.4 倍。

摩尔定律只有在缩小精度的幌子下才真正存在,而不是在缩小晶体管的幌子上。FP2 有人吗?正如一些人所说,FP1 中没有意义。

关键词: GPU

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码