边缘侧 AI 工作负载的系统性演进

——在性能确定性、隐私保护与安全可信之间构建工程闭环

一、从“算力在哪里”到“系统责任在哪里”

如果说早期 AI 架构讨论的核心问题是“算力是否足够”,那么在 2025 年,这个问题已经明显过时。真正困扰产业的,是系统责任的归属:

决策是在云端完成,还是在设备本地完成?

数据风险由谁承担?

性能抖动导致的系统失效由谁负责?

在自动驾驶、工业自动化、医疗设备和智能家居等领域,AI 推理结果往往直接触发物理世界的动作。这使得“低延迟、确定性响应、可验证安全”不再是优化指标,而是准入门槛。

正是在这一背景下,AI 工作负载开始系统性地从云端向边缘迁移。

二、边缘 AI 的本质优势:确定性,而非极限性能

在讨论中,多位专家反复强调一个容易被忽略的事实:

边缘 AI 的价值,并不在于更高的峰值算力,而在于更可预测的行为。

云端 AI 的核心优势在于:

资源弹性;

模型快速迭代;

规模化成本摊薄。

但其弱点同样明显:

网络延迟不可控;

带宽竞争;

加密、重传、排队等系统级不确定性。

相比之下,边缘侧 AI 即便算力有限,却能提供:

毫秒级稳定延迟;

本地闭环控制;

不依赖外部网络的鲁棒性。

在工程实践中,确定性往往比平均性能更重要。

三、数据治理视角下的“边缘优先”原则

Siemens EDA 的代表从数据治理角度,将 AI 数据处理划分为三个层级:

感知级数据(原始传感器输入)

决策级数据(推理中间状态与结果)

演进级数据(用于模型改进的统计样本)

1. 感知与决策数据:天然属于边缘

家庭机器人、车载摄像头、工业视觉系统所采集的数据,往往包含:

个人隐私;

企业机密;

场景语义信息。

这些数据一旦脱离设备,就会引发合规与信任问题。因此,感知级与决策级数据必须默认在本地完成处理。

2. 演进数据:有限、可控地回流

完全不回传数据会导致模型“静态化”。因此,系统通常会将:

异常事件;

决策失败案例;

特定触发条件下的统计特征

以匿名化、去标识化的方式上传,用于模型再训练。这种设计体现的是一种工程妥协,而非技术理想化。

四、内存:边缘 AI 的“隐形天花板”

在算力之外,内存正在成为边缘 AI 的第一约束条件。

1. 模型规模与数据并存

即便经过剪枝和量化,主流感知模型仍需要:

数百 MB 的权重;

大量中间激活值缓存;

高频访问的上下文数据。

这对边缘 SoC 提出了三重挑战:

容量不足;

带宽受限;

访问能耗过高。

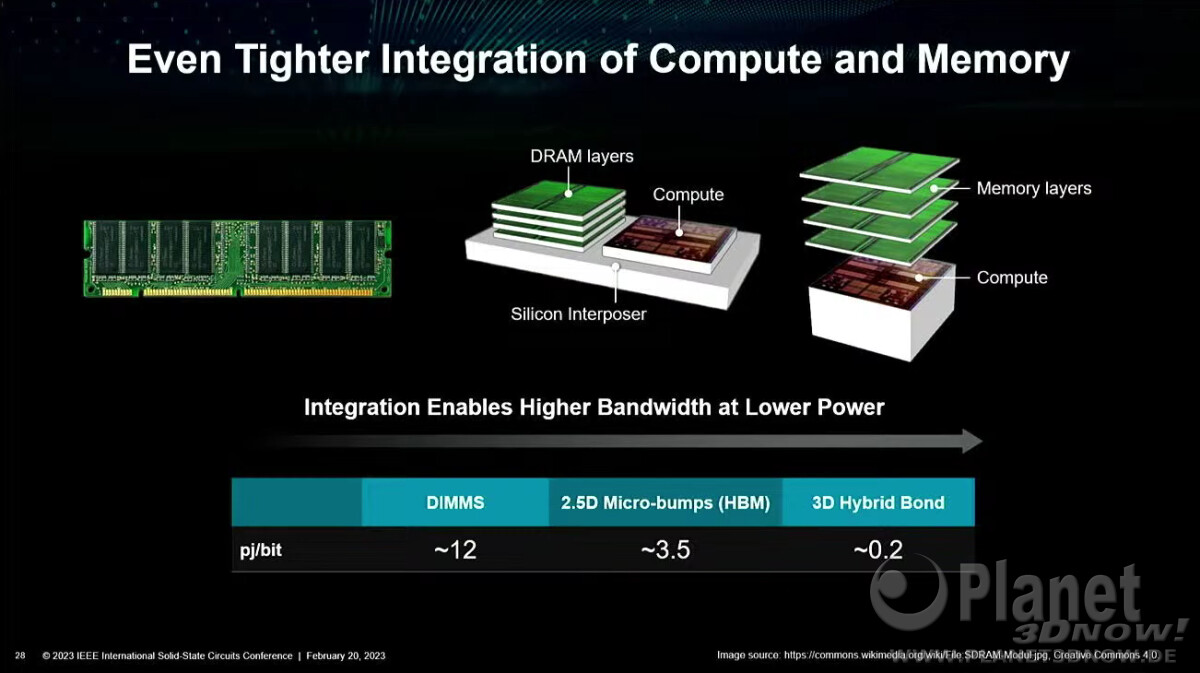

2. 共封装 DRAM:性能与安全的交汇点

Infineon 提到的 DRAM 共封装方案,并非单纯为了“更大内存”,而是为了:

降低物理攻击面;

缩短数据通路;

在封装层实现安全隔离。

这意味着,封装本身正在成为系统安全的一部分,而不再只是制造工艺问题。

五、从“加密”到“全生命周期保护”的安全升级

Rambus 提出的安全框架值得特别强调。传统安全设计通常只覆盖:

数据在传输中;

数据在存储中。

但 AI 工作负载引入了第三个、也是最难保护的状态:

数据在使用中(Data in Use)

近期曝光的 TEE Fail 攻击表明,即便在“可信执行环境”中,侧信道和实现缺陷仍可能导致泄露。

因此,新的安全范式要求:

解密窗口最小化;

密钥动态管理;

硬件、固件、软件协同验证;

覆盖供应链与物理攻击。

安全不再是“模块”,而是系统属性。

六、加密与网络:为什么云端推理越来越“昂贵”

Keysight 从测试与网络角度指出了一个现实问题:

数据包丢失主要发生在网络层;

加密数据包的丢失代价更高;

实时 AI 对重传极其敏感。

这意味着:

云端推理在安全要求提高后,系统开销呈非线性上升;

边缘推理反而成为“更经济”的选择。

这也是为什么,在推理阶段,AI 正在不可逆地向边缘迁移。

七、AI 芯片设计范式的根本转向

Siemens EDA 用一个关键词总结当前趋势:

从“硬件定义软件”到“软件定义硬件”。

1. GPU 的局限性逐渐显现

GPU 的优势在于通用性,但其问题也越来越明显:

功耗高;

数据搬移成本大;

对嵌入式场景不友好。

2. NPU/TPU 与专用加速器的崛起

面向特定工作负载优化的 NPU,能够在:

能效;

延迟;

确定性

方面显著优于 GPU。这也是 Tesla 等厂商选择自研 AI 芯片的根本原因。

八、EDA 与工具链:追赶变化最快的一环

Synopsys 提到一个被低估的矛盾:

算法迭代周期:几周到几个月;

芯片生命周期:5–10 年。

这迫使边缘 AI 芯片必须具备:

高度可编程性;

面向未来模型的弹性;

在功耗和面积上的严格约束。

EDA 工具正在从“验证设计正确性”,转向:

协助系统级探索;

提前评估架构选择对 AI 工作负载的影响。

九、TOPS 指标的失效与系统级性能观

Infineon 明确指出:

单一 TOPS 指标无法反映真实边缘 AI 性能。

真正决定性能的,是:

内存层级;

NoC 架构;

数据复用策略;

软件映射效率。

在很多案例中,架构优化带来的性能提升,远高于算力翻倍。

十、多厂商、多生态:边缘 AI 的现实复杂性

Keysight 以移动终端和 6G 为例指出,未来设备中可能同时存在:

多个 NPU;

不同厂商的软件栈;

通信协议内嵌 AI 模型。

这对硬件提出了前所未有的要求:

跨生态兼容;

动态调度;

可验证协同。

十一、极限协同设计与标准的重要性回归

Siemens EDA 将当前阶段称为:

Extreme Co-Design(极限软硬件协同设计)

其核心特征是:

架构、算法、系统同时设计;

厂商之间提前协同;

打破传统分工边界。

Rambus 最后强调:

没有标准,就没有规模化生态。

标准虽然滞后,但它是防止边缘 AI 走向碎片化和封闭化的唯一现实工具。

十二、结语:边缘 AI 是系统工程的必然选择

综合本次讨论可以得出一个清晰结论:

边缘 AI 的成功,不取决于单点技术突破,而取决于系统级平衡能力。

未来成熟的边缘 AI 平台,必然具备:

数据默认本地处理;

全生命周期安全;

架构驱动性能;

软硬件深度协同;

面向标准和生态开放。

这不是一次简单的“算力下沉”,而是一场AI 工程范式的重构。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码