未来的危机:人工智能数据中心的功耗

人工智能数据中心的能源消耗速度大约是电网新增电力速度的四倍,这为发电地点、人工智能数据中心的建设地点以及更高效的系统、芯片和软件架构的根本转变奠定了基础。

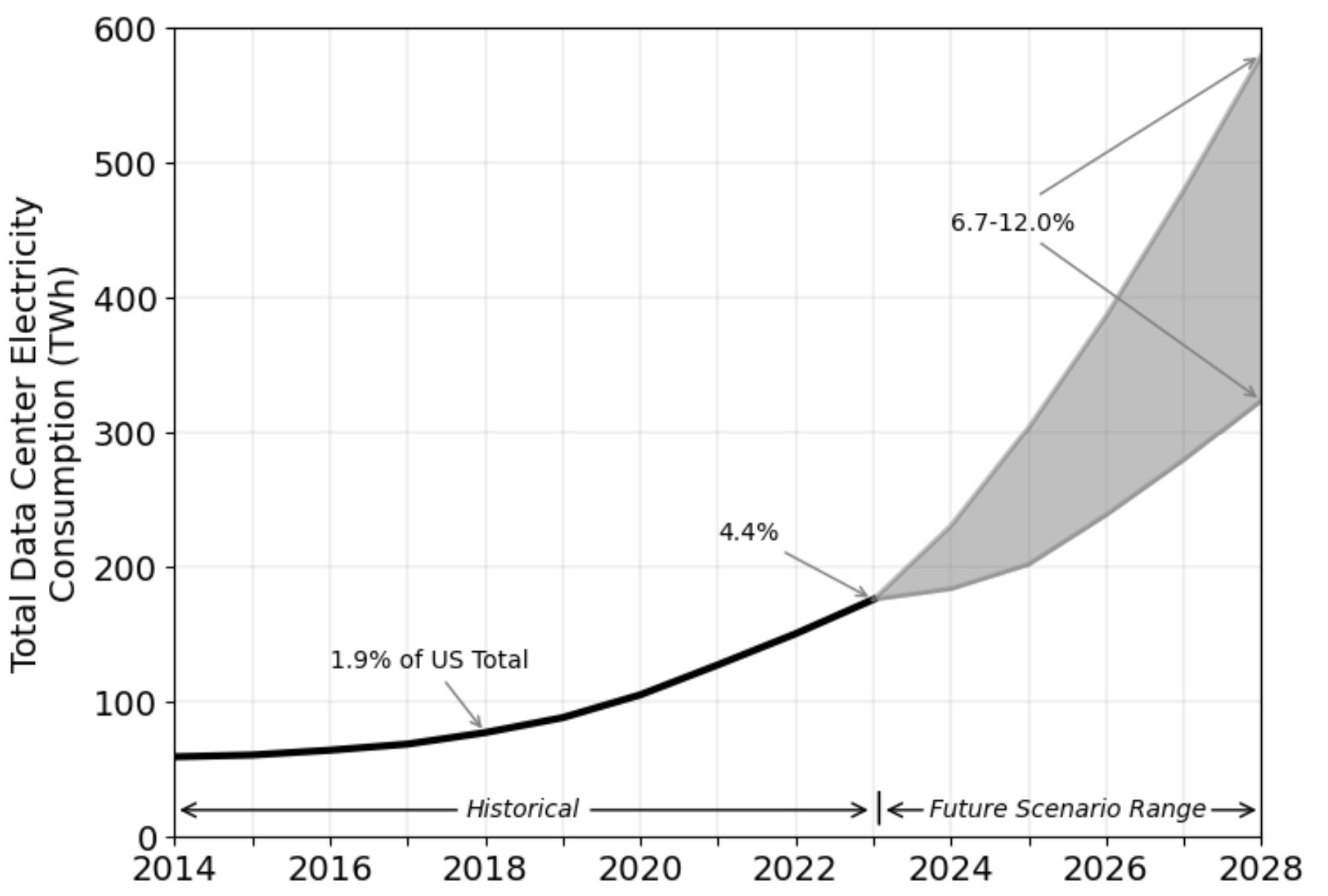

对于美国和中国来说,这些数字尤其引人注目,它们正在竞相扩大人工智能数据中心。美国能源部委托编写的一份 2024 年报告显示,去年,美国数据中心消耗了约 4.4% 的总发电量,约合 176 太瓦时。预计到 2028 年,这一数字将增加到 325 至 580 太瓦时,分别占美国所有发电量的 6.7% 至 12%。

图 1:2014 年至 2028 年总发电量与服务器存储、网络设备和基础设施消耗量(估计)。资料来源:劳伦斯伯克利国家实验室报告[1]

与此同时,中国预计到明年将达到 400 太瓦时,虽然这些数字看起来与美国的消费量相当,但国际能源署指出[2],中国公民的能源消耗量明显低于美国公民。在全球范围内,消费率每年增长 30%,这主要是由于人工智能,美国和中国约占其中 80%。

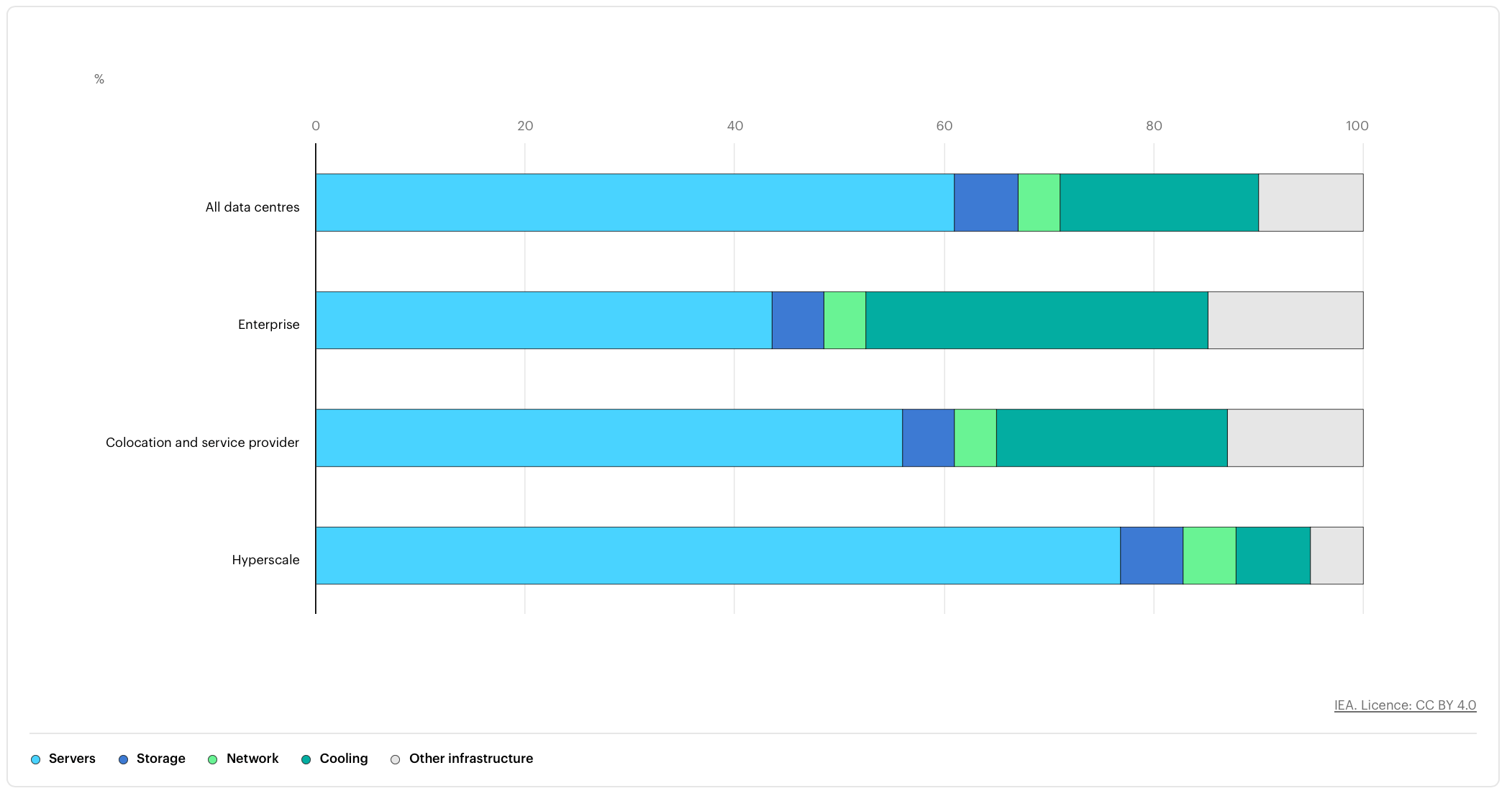

图 2:用电的位置。资料来源:国际能源署

“电源不再是开玩笑了,”西门子 EDA 副总裁兼硬件辅助验证总经理 Jean-Marie Brunet 说。“想象一下,如果 2028 年数据中心的功耗占美国整个功耗的 12%。这太疯狂了。我们必须重做整个电网。

其他人也同意。“发电将是一件大事,”NVIDIA 总裁兼首席执行官黄仁勋在最近与 Cadence 首席执行官 Anirudh Devgan 的 CDNLive 讨论中指出。“原因是电网不足以维持这个行业的增长。我们想在岸上建立这个行业,如果你想这样做,那么我们将看到很多柴油发电机和各种东西。

那么我们能做些什么呢?有四个主要目标领域,每个领域都直接涉及半导体行业:

减少传输距离和降压电压数量;

尽可能限制数据移动;

更高效的处理,以及

在靠近加工元件或包装内部时冷却效果更好。

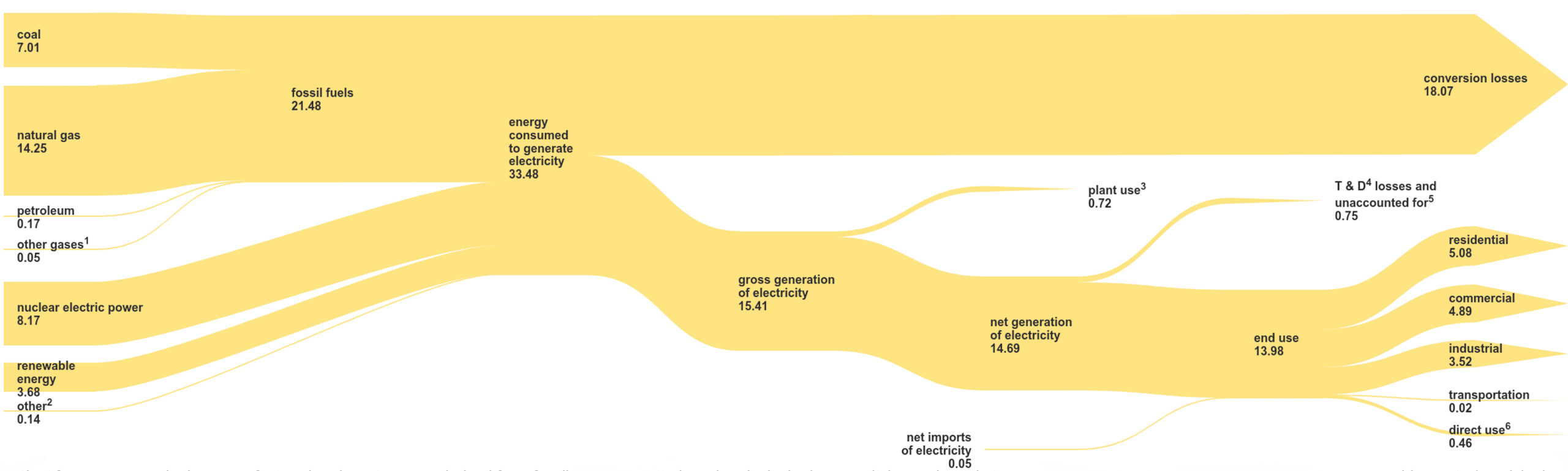

距离和降压损耗与数据

一样,移动电力也存在成本。根据美国能源信息署的数据,在输配电过程中平均损失 5% 的电力。违反直觉的是,长达数百英里的高压线路的损耗(约 2%)低于运行较短距离的低压线路(约 4%)。这些数字也会因来源而复合,因为不同的来源具有不同的转化率(见下图 3)。

图 3:以千万亿 BTU 为单位的美国电流。来源:美国能源信息署,2025 年 4 月

“理想情况下,您将电压保持在尽可能高的位置,这意味着电流尽可能低,”Saras Micro Devices 首席商务官 Eelco Bergman 说。“损失是当前乘以阻力的平方。所以你全程都在失去动力。无论高压电线是什么,你都要不断降低它。这可能是 400 伏电压进入数据中心,然后转换为机架的 48 伏电压,然后最终降至 12 伏到负载点。但是,在每一步,您都希望在数据中心旁边发电,以缩短距离并保持尽可能高的电压,并使电压更靠近您的端点。“

这里的权衡是电压与电流。电流越高,热量越大。没有什么是 100% 高效的,因此当电源靠近封装时,会产生一些热量。反过来,封装内部发生的一切(包括处理数据、在内存中来回移动数据以及互连中的电阻/电容)使情况变得更加复杂。最重要的是,人工智能数据中心需要处理更多的数据,因此这些工作负载需要更高的利用率,这使得跟上需要散发的热量变得更加困难。

因此,从高压线到低压线,再到 PCB、封装,最后是单个芯片,Bergman 说,在此过程中的每一步都会断电。“你如何缩短距离?我可以尽可能接近多少电压?效率如何?我能散热吗?这些都是行业正在关注的事情。

芯片产业在这里可以发挥很大的作用。“由于现有基础设施的原因,我们有太多的中间电压水平,”弗劳恩霍夫 IIS 自适应系统工程部高效电子部门负责人 Andy Heinig 说。“当然,我们可以在这里节省大量能源。我们还看到处理器和电源稳压器需要协同工作。目前,电源调节器并不智能。它们只遵循来自处理器的电流。但处理器知道他们在下一个周期中必须做什么,他们可以通知电源转换器巨大的跳跃即将到来或某些东西被关闭。因此,在某些方面,我们可以共同优化处理器和稳压器,减少中间电压电平的数量会有所帮助。

移动数据

另一个挑战是构建系统,以便在更靠近源的位置处理数据。这减少了需要移动的数据量。但除此之外,数据必须传输的距离也需要缩短。这是 3D-IC 封装背后的关键驱动力之一。组件可以战略性地垂直放置以缩短这些距离,而不是在 SoC 上布线。这提高了性能,以及驱动信号所需的功率。

“目前我们客户面临的最大挑战之一是设计中的线材长度,”Arteris 产品管理和营销副总裁 Andy Nightingale 说。“多芯片是一项单独的挑战,但在每个单片芯片上,在进入多芯片之前,缩短导线长度对于电源至关重要。我们关注的一个方面是拥堵。我们在设计分析中也有热图,用于查看拥塞,因为这是许多电线在交换机上相遇的关键点。我们也在平面图内工作,我们将物理设计可视化,这样我们就可以将交换机移出拥塞点,同时仍然在平面图内工作,以减少一个区域的散热和电力拥塞。

这也需要转变思维方式,因为在人工智能数据中心中,功率仍然让位于性能。但如果没有更多的电力可用,或者电价飞涨,那么人工智能公司将别无选择,只能认真对待电力。

“如今,人工智能设计的重点仍然是性能,这意味着虽然功耗真的非常重要,但它仍然是从这些芯片中获得最佳速度和性能的次要问题,”Ansys(现为新思科技的一部分)产品营销总监Marc Swinnen说。“总是存在功率/性能权衡,这是根本。所以如果你真的想降低功率,你就必须降低性能。遵循摩尔定律会有所帮助。这降低了功率。另一件事是,大部分功能都在 GPU 和不同元件之间的通信中,甚至是数据中心的背板。NVIDIA 推出了共同封装的光学网络,只是为了降低机架内和机架之间的通信功率。

解决这些问题需要整个芯片行业的变革。“它从芯片开始,如果芯片非常耗电,而你想构建一个法学硕士,那么你必须训练这个东西,”西门子的布鲁内特说。“你通过添加多个函数和扩展来训练它。但是,如果把事情加起来,从一个非常耗电的元件开始,那么整个系统就会非常耗电。您还有一个数字孪生,您还需要大量的能力来计算该数字孪生。但这不仅仅是 EDA 行业的问题。这是全世界的问题。

更高效的加工

好消息是,有一些明显的唾手可得的成果。“仅仅因为缺乏知名度,就要征收 20% 的电税,”Movellus 总裁兼首席执行官 Mo Faisal 说。“例如,假设您设计了一个 2 GHz 时功率为 500 瓦的芯片。当您完成系统级测试并准备好进行部署时,您会发现所有这些电力系统都是根据不同的目标构建的。所以现在,如果你想保持在 500 瓦以内,你必须将频率降低 10% 到 20%。它基本上是一个节流阀。而对于 chiplets,情况只会变得更糟,因为现在你有同样的东西,但你把它乘以你正在处理的小芯片的数量。每个小芯片可能具有不同的工艺角,或者它可能位于不同的工艺中。

这是图片的一部分。“通过安装从芯片到系统一直到数据中心的更多可见性,可以额外获得 20% 到 30% 的收益,”Faisal 说。“而且这两者都是复合的,所以它不是非此即彼的。原因是芯片设计者担心风险。“嘿,我可不想让芯片出现故障。因此,他们将通过冗余来超额计算。但在部署中,当您设计数据中心时,您并没有为最大工作负载而设计它。您正在针对峰值工作负载进行设计。原因是工作负载和软件的变化速度比芯片快得多。不可能用你在现场看到的所有工作负载组合来测试芯片,因为工作负载、模型、转换器和代理都在变化得太快了。所以你必须把它留出边距。与您在最大负载中看到的容量相比,数据中心容量超额预置了 30%。

了解半导体的使用方式对于这个方程式也至关重要。在最坏的极端情况下,仅添加冗余和保护带即可增加通过额外电路驱动信号所需的功率,以及由于导线中的电阻/电容而需要消散的热量。

摩尔定律在这里也起着作用。虽然每个新工艺节点的处理器性能改进都在减少,但功耗的改进预计将大幅增加 — 高达 30%,具体取决于工艺和代工厂。与任何新流程一样,这些数字可能会因架构和工作负载的不同而有很大差异。

冷却

经验法则是数据中心支付两次电费。第一次是为服务器和存储的机架供电。第二次是冷却它们,这样它们就不会过热,这正在成为一个更大的问题,因为动态电流密度随着人工智能服务器的利用率而增加。训练大型(甚至小型)语言模型以及支持生成式和代理式 AI 搜索需要更多的处理。这反过来又增加了各种计算元素的利用率,因此它们在更长的时间内以全孔运行。

“冷却的功率开销约为 30% 到 40%,在没有冷却器的情况下进行液体冷却,您可以将其减少一半,”Saras Bergman 说。“但是,如果你添加冷却器,它就会立即回升。这里有一个优化游戏需要玩。

这个方程式中的枢轴点是水的可用性。封闭系统中的自来水需要冷却。使用当地供水则不会。但根据环境与能源研究所的数据,一个大型数据中心每天可以消耗多达 500 万加仑的水,这大约是一个拥有 10,000 到 50,000 人的城镇的消耗量。

两种选择是单个芯片的直接冷却和浸入式冷却。直接冷却可能涉及微流体通道,这是 IBM 在 1980 年代首次提出的一个想法,后来因为太难而放弃了。但随着热密度的增加,芯片制造商可能别无选择,只能使用某种类型的微流体。尽管如此,实施这种方法会增加结构和制造方面的挑战。这个想法很好理解,因为水冷已经使用了半个多世纪。但是,在更靠近晶体管的封装或芯片中实现它仍然是一个挑战。

“如果你正在研究冷却技术,就会有传热效率,这往往是从热阻的角度来看的,以及一般意义上的结到流体的温度,”英特尔高级首席工程师兼公司热核心能力小组负责人 Rajiv Mongia 解释道。“但如果你想从热力学的角度来看待它,它不是结到流体的入口温度。这是结到流体的出口温度。基本上,当您离开封装或封装区域时,流体温度越高,从传热的角度来看,下游的所有东西就越容易进行管理。这会影响冷却设备、冷水机组和所有这些东西的整体效率。

这是堆叠模具的一个关键考虑因素。“当我们使用 3D-IC 时,您可能需要在结构本身内获得流体,例如芯片背面的硅微通道,”Mongia 说。“这是一个收益与复杂性的比率。你可以用这种放在背面的盘子来冷却它。但是,一旦您在 3D 堆栈中进行了足够的体积加热(想象某种立方体),您就无法再通过硅的一侧将热量传导出来。你必须以某种方式从硅内部吸收热量。归根结底,将需要一些奇特的机制,因为你在该体积的硅内产生如此多的功率,而不仅仅是在一个表面上。

相比之下,浸入式冷却涉及将整个服务器放入惰性液体中。这里的挑战与微流体相同。热量需要从机架内部吸出,将封装内部的热负荷散发到外部冷却槽比听起来更复杂。它需要了解封装中元件的放置位置、潜在的热界面材料以及从数字逻辑到封装外部的热通道。

这两种方法也可以一起使用来大幅降低热量,从而实现均匀的晶体管密度和更大的电力需求。

资金和资源

芯片行业不会失去这些。为了至少像今天一样向前发展并继续增长,需要解决两个相关问题 — 可持续性和成本。这些最终将决定 AI 数据中心的部署速度、它们可以处理的处理量,以及从传输角度和芯片/系统/封装设计角度来看需要做出哪些改变。

“可持续发展一直成为等式的一部分,因为几十年来,企业一直面临着更好地利用我们的自然资源的压力,”西门子数字工业软件首席执行官迈克·埃洛 (Mike Ellow) 说。“这就是我们的前进方向,以半导体为支柱,将帮助许多行业。如果您看看数据中心的功耗,我们就会发现我们的发展方向是不可持续的。对我们来说,挑战是如何将四倍、五倍或六倍的计算能力放入该数据中心已经存在的相同功率配置文件中。

商业基础知识也参与了这幅图景。“归根结底,这是总拥有成本,”英特尔的 Mongia 说。“无论是你正在创建的大型语言模型还是你试图生成的推理,都要付出资本成本和运营成本。热能与资本成本和运营成本有关。那么平衡是什么呢?投资回报率是多少?升级到液体冷却解决方案需要多少成本,因为从历史上看,这些解决方案比空气冷却更昂贵。所有这些人工智能数据中心或人工智能解决方案主要是液冷的。为了让我们构建它,您需要从您的软件包中获得更多收益,这意味着在生成语言模型时获得更多的推理或更高的性能,从而随着时间的推移降低运营成本。

结论

为了正确看待这一点,请考虑内华达州的胡佛水坝每年产生约 4 TWh;亚利桑那州帕洛维德核电站年发电量为32太瓦时,中国三峡大坝预计年发电量为90太瓦时。但在 2028 年至 2030 年间,考虑到目前的增长率,人工智能数据中心的电力需求将增加 350 太瓦时,几乎是所有这些发电设施总和的三倍。[2]

任何单一的改变都不会缩小这种差距。半导体行业要想继续以目前的速度增长,就需要从电网开始,从芯片开始发生变化。即便如此,目前尚不清楚这是否真的会缩小差距,或者是否只会让 AI 数据中心变得更大。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码