R1芯片:Apple Vision Pro中最神秘的角落

没错,看到标题各位一定已经知道了,本篇文章我们接着来聊一聊Apple Vision Pro。Apple Vision Pro在北美正式发售至今已经过了一个月多了,笔者也是写了数篇文章来讲解了这款Apple全新的空间计算设备,那为什么今天还来探讨Apple Vision Pro呢?因为,笔者突然意识到有一个十分重要的部件,一直没有涉及,这便是Apple Vision Pro之中全新搭载的芯片,用于空间计算的R1芯片。

单从Apple发布会的公开信息来看,R1 芯片是为应对实时传感器处理任务而设计的。它负责处理来自12个摄像头、5个传感器和6个麦克风的数据,这样的设计使得R1几乎消灭了延时,确保新图像能在极短的时间内(12毫秒)传输到显示屏,这一速度甚至快达眨眼速度的8倍。与此同时,M2芯片负责Vision Pro自身的运转性能,而R1则专注于确保用户能够获得如同发生在面前般的实时体验。总结来看,R1主要承担的是传感器数据的处理和部分图像处理的任务。

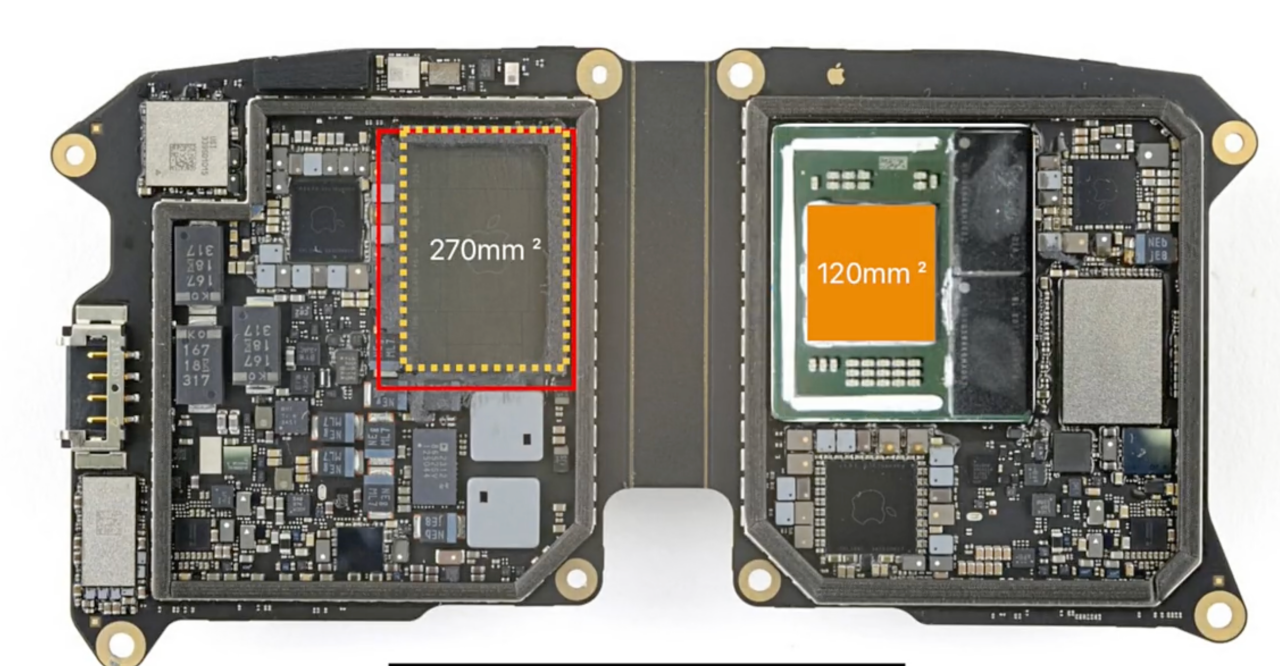

显然这些信息很难让我们了解这颗R1芯片具体是什么,它又在Apple Vision Pro之中具体起到了哪些作用。而近期流出的一些Apple Vision Pro的拆解图,再结合一下Apple自己发布的专利信息,我们也许可以一窥一二。从拆解之中,我们可以清晰得发现,R1芯片相比于M2芯片来说规模着实是不小,根据测量,R1的芯片面积为270平方毫米,而旁边的M2芯片只有120平方毫米。而更进一步来看,可以发现R1芯片有十分明显的对称Chiplet封装的痕迹,总共5种,共计11颗芯片。

根据一些分析机构的资料,大致可以看出,R1芯片采用了台积电的Fan-out扇出型封装技术。所谓“扇出型封装技术”,其采取在芯片尺寸以外的区域做I/O接点的布线设计,提高I/O接点数量。采用RDL工艺让芯片可以使用的布线区域增加,充分利用到芯片的有效面积,达到降低成本的目的。扇出型封装技术完成芯片锡球连接后,不需要使用封装载板便可直接焊接在印刷线路板上,这样可以缩短信号传输距离,提高电学性能。

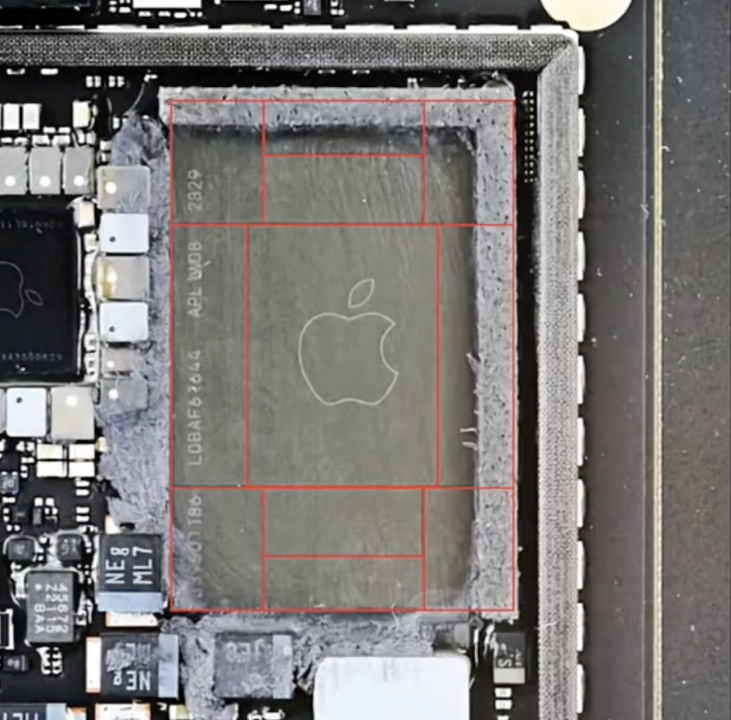

这一封装技术为R1芯片提供了独特的结构和功能,使其能够高效处理从头显各处的摄像头、麦克风等传感器收集的大量数据。可见该封装也一定是Apple所宣传的Vision Pro只有12ms的光子延时的底气来源之一。进一步看R1的封装,可以发现其封装形式与大多数手机处理器等有所不同。它仅由扇出金属化组成,这种设计形成了内部连接和R1以外的系统级连接。在拆解分析中,还发现R1内部包含三个功能芯片:一个台积电制造的处理器位于中央,以及两个专门的SK海力士存储芯片。这些芯片通过扇出金属化被缝合在一起,形成了高密度互连垫的边缘区域。值得注意的是,在R1封装中,除了这三个有源芯片外,还有八个虚拟硅晶片围绕在它们周围。这些虚拟硅晶片填满了封装足迹,但实际上除了单纯的硅之外,并没有任何电路和功能。

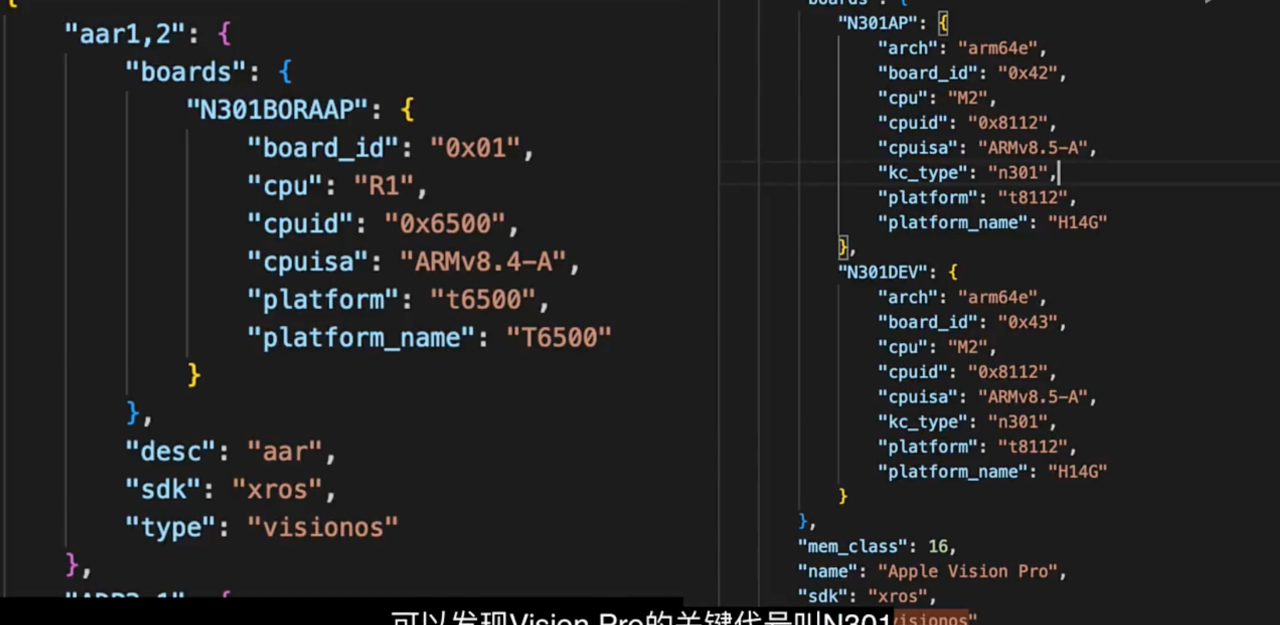

当我们打开Apple自己的iBoot配置文件的时候,我们又能看到更多关于R1的信息,我们可以发现R1的架构是Arm v8.4,根据B站up主@Luv Letter的信息,A12的架构是v8.3,而A14的架构是v8.5,那么至此我们就能得到这样一个简单明了的结论,R1和A13处理器同源,其中应该有大量A13或者同源M1芯片的技术。而且不难发现,R1的代号为N301BORAAP,这能看出在Apple的定义中,R1很可能不是一个简单的信号处理芯片,而是和M2类似的应用处理芯片。而当我们去翻阅一些apple自己的专利文件时,也会发现在

而当我们去翻阅一些Apple自己的专利文件时,也会发现在一篇名为 《Video Pipeline》的Apple Vision Pro的专利时,其内容更是直接表示了R1内部集成了GPU,那我们就能给这颗R1芯片下一个初步的定义了,它在Apple Vision Pro中是一个主要负责双目渲染的高性能应用处理器。

至此,我们还有一个问题需要回答,落实到实处,R1的加入究竟给用户带来了什么具体的效果体验呢?如果您在之前体验过Meta的Quest系列VR头显设备,也许会对其对于用户手部扣像的体验记忆深刻,此功能为用户提供了无需佩戴额外控制器就能与虚拟世界进行交互的能力,其可以直接用使用者自己的双手在虚拟环境中进行操作,比如抓取物品、操纵界面元素等。这种自然的交互方式大大增强了虚拟现实的沉浸感,使用户感觉更加身临其境。极大的增加了VR的沉浸感。但是Quest给出的手部扣像方案的精度十分感人,在用户的手距离眼睛过近之时还有严重的畸变。而产生这种现象的根本原因就是捕捉外部画面的摄像头一定会和用户的眼睛不在同一个位置,因此摄像头捕捉的画面和用户眼睛能看到的画面范围一定不会完全重合,当用户的手移动到摄像头盲区时,就只能通过这种“拙劣”的计算和拉伸画面来填补画面中看不到的地方,从而就变成了用户看到手部周围有严重的畸变,对于沉浸感一定会有不小的影响。

Quest的手部扣像并不精准,且有严重畸变

在Apple Vision Pro中,Apple则是实现了更加精准可用且几乎没有畸变的手部扣像效果,而着背后的计算很大概率就是R1所完成的。那么Apple是如何做到几乎完美的手部扣像效果的呢?我们还是要再一次回到Apple的专利之中寻找答案。

Apple给出的方案,手部就被精准扣出,且几乎无畸变

首先,既然摄像头和人眼之间存在误差,那么首要就是通过计算尽可能得将摄像头画面投射到人眼之中,这里面需要知道物理精准的距离,这时就需要ToF镜头和LiDAR(激光雷达)融合AI来计算物体的距离,也就是对外界世界敬请建模;其次,我们上文提到过,摄像头存在和眼睛不重合的区域,在摄像头看不见的地方,要怎样真实还原呢?Apple给出了一个十分聪明的做法,那便是通过一系列的摄像头相互补充画面,比如在右眼附近的摄像头看不到的区域,就使用左眼的摄像头来捕捉,把画面还原,之后利用“注视点机制”将缝合后的画面羽化掉,从而达到一个自然的扣图效果。在这个过程中,M2负责所有的计算,而R1就负责最终的画面矫正和输出。

最后总结一下,Apple通过M2芯片和R1芯片来共同实现Apple Vision Pro的空间体验。这两个芯片的大致分工是M2芯片负责运行visionOS(Apple Vision Pro的专属操作系统,类似iOS,iPad OS),运行计算机视觉算法,提供图形运算和显示,类似于电脑里的CPU+GPU的综合体;R1芯片专门用于处理来自摄像头、传感器和麦克风的输入信息,在12毫秒内将图像传输到显示器(划重点),从而实现几乎无延迟的实时视图。

关键词: Apple XR头显 Vision Pro R1 SoC

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码