Xilinx AI 加速+阿里云 FaaS:开启云端 AI 推断巨大机遇

中国是全球最大的在线零售市场,而阿里巴巴则是中国最大的电子商务公司。作为阿里巴巴集团旗下的云计算和数据智能部门,阿里云为国际客户的在线业务及阿里巴巴集团自身的电子商务生态系统提供综合全面的成套全球云计算服务。在公有云服务提供商市场上,阿里云的市场份额位居亚太地区首位。

阿里云的业务之一是为众多第三方厂商处理海量产品图像。由于一些图像内含有未付费广告等多余文本信息,给付费广告业务造成不利影响,因此,为了确保电子商务网站提供一致的体验,需要以 AI 推断对每天数千万幅图像中嵌入的有害文本或多余文本进行检测,随之而来的是巨大的 AI 推断计算工作负载以及高昂的运营成本。

借助 ML 框架在赛灵思 FPGA 上直接加速 Yolo-v2

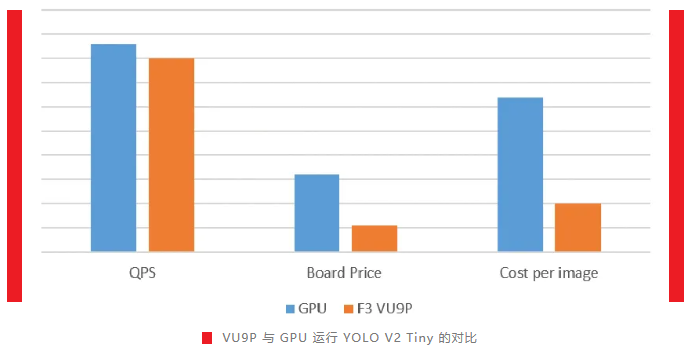

阿里巴巴过去使用 GPU 运行 Yolo-v2 Tiny(数据类型为 Float32),通过这种方法掌握每日千万级的图像内容。由于该架构未经充分优化,GPU 只能实现有限的每秒查询次数 (QPS) 吞吐量,导致用电成本高、服务器空间占用大。为了降低运营费用,阿里巴巴寻求比 GPU 成本更低的解决方案来检测有害或多余的文本信息。

依托于赛灵思 16nm Virtex UltraScale+™ FPGA 的高度自适应架构,阿里云 FaaS 团队在 Int16 上运行 Yolo-v2 Tiny 模型,在媲美 GPU 精度的前提下实现一流的 QPS 性能。单片赛灵思 UltraScale+ FPGA 每秒能处理数百幅图片,与最初的 GPU 实现方案相比性能提高 3.5 倍。在 FaaS 的启发下,虽然GPU通过完成类似优化也可以达到类似性能,但赛灵思解决方案的单幅图像成本更低。除此之外,赛灵思 Vitis AI 在加快开发速度方面也有着上佳表现。

在不降低精度的前提下节省 75% 总拥有成本

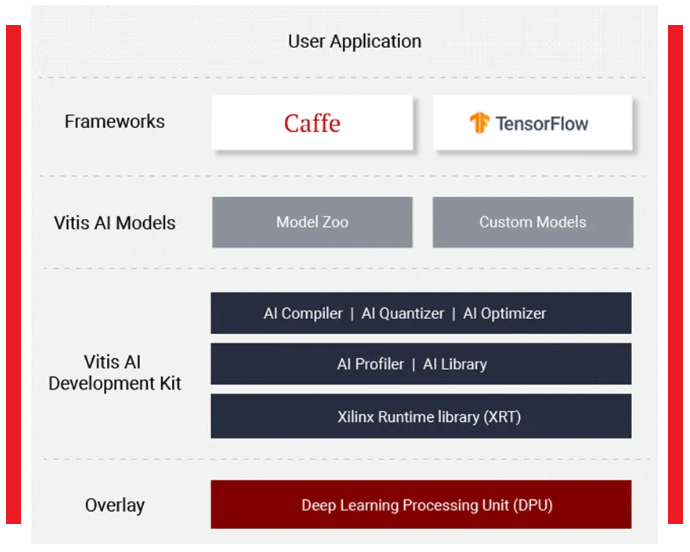

Vitis AI 支持开发者在无需编写任何 RTL 代码的情况下,优化 DNN 模型并将预训练的 DNN 模型部署到赛灵思 FPGA 中。其运行时及外壳程序让开发者无需成为 FPGA 专家就能够充分从赛灵思硬件加速中获益。

阿里巴巴云和智能FPGA异构计算负责人张振祥负责领导该项目并成功在 F3 实例上实施了 AI 加速。

阿里云 FaaS 在云端提供统一的硬件平台与中间件。在赛灵思 Vitis AI 的支持下,阿里云 FaaS 能够大幅降低 AI 加速器的开发成本与部署成本。加速器厂商可以将加速器以服务形式提供给用户,克服加速技术的硬件壁垒。用户可以按需使用加速服务,不必理解底层硬件详情。借助 Vitis AI,阿里巴巴和赛灵思联合开发 AI 加速解决方案的最大优势在于,阿里巴巴不需要任何人成为使用 FPGA 技术的专家。

此外,张振祥还指出:“起初,很多人对于将 FPGA 用于 AI 领域的前景并不看好,因为 GPU 使用方便且支持所有框架。但是,阿里云与赛灵思合作充分证明了其实 FPGA 更适合该领域中的特定场景。”

▅ 赛灵思 Vitis AI 堆栈

FPGA 更适合!

FPGA 更适合某些领域中的特定场景,尤其是在云 AI 推断方面有显著的成本优势。例如:

○ 云端外壳程序使开发工作大幅简化;

○ 小宽度及修剪所需成本及功耗大幅降低;

○ 图像锐化及 FFT 过滤器等 IP 会为部分创新应用创造额外价值。

通过 FaaS 平台,加上大量的 ISV 及独立的 IP 开发商,FPGA 会在云端 AI 推断领域迎来大量机遇。

阿里巴巴云和智能FPGA异构计算负责人:张振祥

点击了解 FPGA 实例概述。

赛灵思官方微信号:xilinx_inc

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码